Ein persönlicher Blick eines IT-Leiters auf die Geschichte der Informatik – und die Verantwortung, Talente unabhängig vom Geschlecht zu fördern

Wenn man wie ich seit vielen Jahren in der IT arbeitet, beginnt man irgendwann mit einer Mischung aus Staunen und Wehmut auf die Geschichte unserer eigenen Disziplin zu blicken.

Nicht, weil früher alles besser gewesen wäre, sondern weil man erkennt, wie viel Potenzial gesellschaftliche Strukturen beeinflussen – und wie viele Lebenswege anders verlaufen wären, hätte man Menschen nicht anhand von Rollenbildern, sondern anhand ihrer Neugier und Fähigkeiten gefördert.

Die Entwicklung der Informatik ist nicht einfach eine Abfolge technischer Erfindungen. Sie ist vielmehr ein Lebenslauf menschlicher Kreativität – geprägt von brillanten Köpfen, ungenutzten Chancen, sozialer Fehlsteuerung und einer Kraft, die bis heute unsere Welt formt.

1. Die frühen Visionäre (19. Jahrhundert): Als Computer nur in Gedanken existierten

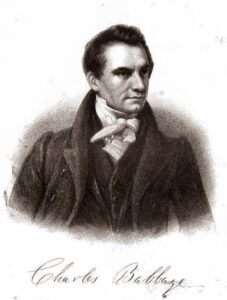

Charles Babbage (1791–1871, England)

Babbage war ein Mathematiker mit einer Idee, die ihrer Zeit nicht nur vorausging – sie passte eigentlich in kein Weltbild des 19. Jahrhunderts:

eine Maschine, die nicht nur Zahlen, sondern abstrakte Abläufe ausführen könnte.

Seine Entwürfe:

Difference Engine (1820er) – mechanischer Rechner für Tabellen

Analytical Engine (1837) – Konzept eines vollwertigen Universalcomputers

Die Analytical Engine war nie fertig gebaut. Doch sie enthielt:

-

- Rechenwerk

- Speicher

- Steuerwerk

- Programme via Lochkarten

Damit war sie im Prinzip ein Computer – ein Jahrhundert vor Zuse.

Ada Lovelace (1815–1852, England)

Ada Lovelace schrieb 1843 das erste Computerprogramm der Welt, obwohl kein Computer existierte. Sie dachte abstrakt genug, um für eine hypothetische Maschine einen Algorithmus zu entwickeln – die Berechnung der Bernoulli-Zahlen.

Noch bemerkenswerter: Sie erkannte als Erste, dass Maschinen Informationen verarbeiten könnten. Sie sprach von Musik, Mustern, Symbolen – ein Softwaredenken, das erst 100 Jahre später seinen praktischen Ausdruck fand.

Dass die erste Programmiererin der Welt eine Frau war, ist kein Randdetail.

Es ist ein Hinweis darauf, wie anders die Geschichte hätte verlaufen können.

2. Die elektromechanische Geburt des Computers (Anfang 20. Jahrhundert)

Alan Turing (1912–1954, England)

Turing schuf 1936 die theoretische Grundlage aller modernen Computer: die Turingmaschine. Ein abstraktes Modell für algorithmische Verarbeitung – bis heute Fundament der theoretischen Informatik.

Während des Zweiten Weltkriegs spielte er zudem eine Schlüsselrolle bei der Entzifferung der Enigma.

Konrad Zuse (1910–1995, Deutschland)

Zuse baute zwischen 1938 und 1941 die ersten funktionierenden programmierbaren Computer der Welt. Seine Z3 (1941) war der erste vollautomatische, programmgesteuerte Rechner – ein Meilenstein, der die gesamte moderne IT ermöglicht hat.

Während Babbage theoretisierte, realisierte Zuse.

Die Informatik nahm Gestalt an.

3. Die ersten elektronischen Giganten (1940–1950)

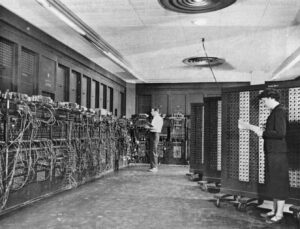

ENIAC (USA, 1945)

Der ENIAC war ein Monster aus Elektronikröhren – groß, heiß, laut und doch der erste wirkliche Vorläufer moderner Systeme.

Entwickelt von:

- John Presper Eckert (1919–1995, USA)

- John Mauchly (1907–1980, USA)

Die ENIAC-Programmiererinnen

Sechs Frauen – Kay McNulty, Betty Jennings, Betty Snyder, Marlyn Wescoff, Fran Bilas und Ruth Lichterman – programmierten ENIAC.

Sie arbeiteten ohne Dokumentation, ohne formale Methoden, ohne Vorbilder.

Sie erfanden Programmierung im eigentlichen Sinne, wurden aber lange Zeit aus der Geschichte gestrichen. Erst in den 1990ern wurden ihre Namen wieder sichtbar.

Die ersten Softwareentwicklerinnen der Welt waren Frauen – und zwar extrem gute.

4. Die Software-Ära beginnt (1950–1970)

Grace Hopper (1906–1992, USA)

Grace Hopper entwickelte 1952 den ersten Compiler – eine Erfindung, die alles veränderte. Sie machte Programmierung verständlicher, strukturierter und nutzbarer für Unternehmen. Später war sie maßgeblich an der Entwicklung von COBOL beteiligt.

In dieser Zeit galt Programmieren gesellschaftlich als „Frauenarbeit“ – analytisch, strukturiert, fleißig. Hardware galt als „Männersache“.

Es ist wichtig, das zu begreifen, um die spätere Entwicklung zu verstehen.

5. Der große Umschwung: Die Homecomputer-Revolution (1970–1990)

Mit dem Aufkommen von Apple II, Commodore und IBM-PC passierte etwas Tragisches – nicht technisch, sondern kulturell:

-

- Computer wurden massiv an Jungen vermarktet.

- Mädchen bekamen andere Spielsachen.

- Erste Programmiererfahrung wurde geschlechtlich gefärbt.

Informatik wurde außerdem zu einem prestigeträchtigen, gut bezahlten Beruf. Und plötzlich „passte“ er gesellschaftlich zu Männern – ein reiner Kulturwechsel, kein Kompetenzwechsel.

Universitäten erwarteten Vorwissen, das aber nur Jungen hatten.

Frauen mussten sich stärker beweisen, wurden häufiger infrage gestellt und erhielten weniger Förderung.

So wurde ein ursprünglich weiblich geprägtes Feld zur Männerdomäne – nicht wegen der Fähigkeiten, sondern wegen der Sozialisierung.

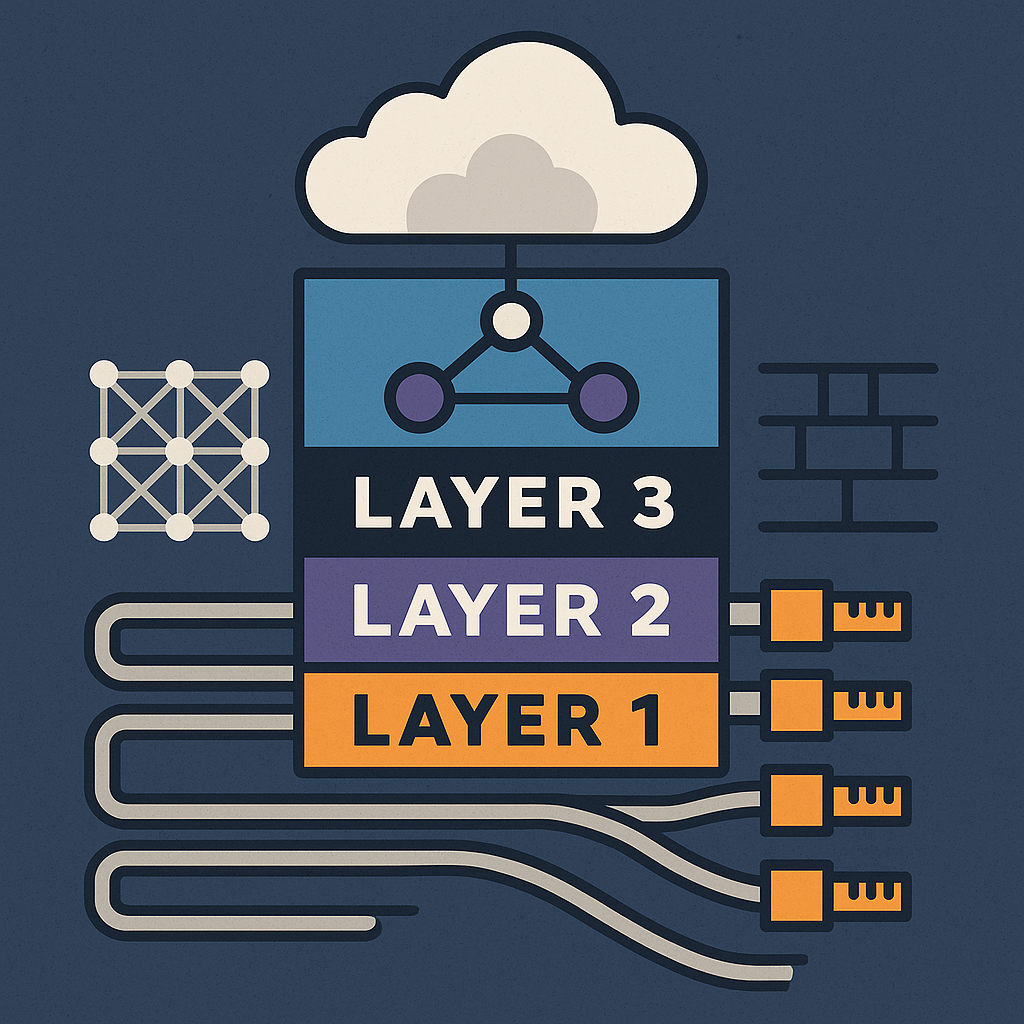

6. Unsichtbare Grundlagen: das Spanning Tree Protocol

Radia Perlman (1951 – heute, USA)

Während in den 1980er-Jahren Personal Computer in die Büros und Wohnzimmer einzogen, entstand im Hintergrund ein anderes technisches Fundament – eins, das bis heute in nahezu jedem Netzwerk aktiv ist.

Die Ingenieurin Radia Perlman entwickelte 1985 das Spanning Tree Protocol (STP), einen Algorithmus, der es ermöglicht, Netzwerke stabil und fehlertolerant zu betreiben.

Das Verfahren löst ein bis dahin hartnäckiges Problem: Werden mehrere Switches miteinander verbunden, können durch redundante Verbindungen Schleifen entstehen, in denen Datenpakete endlos zirkulieren.

STP erkennt diese Situationen automatisch und bildet daraus eine logische, schleifenfreie Baumstruktur. Gleichzeitig bleiben alternative Pfade verfügbar, um Ausfälle abzufangen.

Dieses Prinzip ist bis heute ein fester Bestandteil moderner Netzwerktechnik.

7. Die Gegenwart: Ein Blick aus Sicht eines IT-Leiters

Wenn ich heute als IT-Leiter einer Kollegin begegne, fällt mir oft auf, wie außerordentlich stark sie fachlich unterwegs ist. Nicht, weil Frauen „bessere Informatiker“ wären – sondern weil die Hürden, die sie überwinden mussten, höher waren.

Es ist ein systemischer Filter:

Jede Frau in der IT hat bereits bewiesen, dass sie Widerstände und Vorurteile überstehen kann. Dieser Selektionsdruck führt zu Kompetenz – aber er führt auch zu Verlusten.

Denn jede Frau, die es schafft, steht stellvertretend für viele, die den Weg nicht gehen konnten, obwohl sie denselben Funken in sich trugen.

8. Was wir aus dieser Geschichte lernen müssen

Der wichtigste Punkt für mich als Leiter eines IT-Bereichs ist:

Förderung muss geschlechtsunabhängig, potenzialorientiert und früh beginnen.

Wenn Kinder – völlig unabhängig vom Geschlecht – Zugang zu Werkzeugen, Problemlösung, Experimentierfreude und Technik bekommen, verschwinden die Unterschiede.

Studien zeigen das seit Jahren.

Daraus ergeben sich klare Aufgaben:

-

- Frühen Zugang zu Technik ermöglichen

- Rollenbilder vermeiden („du bist nicht der Typ dafür“)

- Teams divers aufstellen, weil verschiedene Perspektiven bessere Lösungen hervorbringen

- Erfolge sichtbar machen – ohne ein Geschlecht zu überhöhen

- Die Geschichte kennen, um ihre Fehler nicht zu wiederholen

9. Schlusswort: Die Informatik hätte anders aussehen können – und kann es noch

Die Geschichte der IT ist faszinierend, aber auch tragisch.

Wir haben als Gesellschaft viele Talente verloren, weil wir zu spät verstanden haben, dass Begabung nichts mit Geschlecht zu tun hat, sondern mit Neugier, Zugang und Förderung.

Ich bin überzeugt:

Unsere Aufgabe ist nicht, die Vergangenheit zu korrigieren, sondern die Zukunft fairer zu gestalten.

Damit die Informatik von dem lebt, was sie groß gemacht hat:

Menschen, die denken dürfen – frei von Grenzen, frei von Rollenbildern, frei von Erwartungen, die nichts mit Talent zu tun haben.